在企业AI落地实践中,数据/知识质量 是AI可靠性的基石。这一点可用一句俗语概括:垃圾进,垃圾出。如果输入给AI系统的是过时、混乱甚至错误的知识,那么AI输出必然难以令人满意。现实案例表明,不少企业最初构建的知识库缺乏质量管控,导致AI引用了错误版本的政策文件,给出了错误解答。之所以出现这种偏差,正是因为纯粹的技术方案缺乏对知识时效性、权威性的考量 。因此,在启动任何AI应用之前,企业必须先确保其知识语料“干净”和“新鲜”,为AI模型提供高质量、高可信度的知识原料 。正如TorchV AIS知识引擎所强调的,知识构建环节的使命就是从源头上解决“垃圾进,垃圾出”问题,确保进入AI系统的是高质量、高纯度的内容 。

知识需要被好好对待

许多企业早期尝试采用 RAG方案,将大语言模型与企业内部知识库相结合,希望快速构建问答机器人。然而实践证明,RAG方案在生产环境中高达70%以失败告终 。造成失败的根源往往在于对知识管理缺乏系统性方法论,导致以下常见陷阱:

- 知识漂移:企业数据是不断演变的,若缺乏机制感知源数据的变化,AI可能仍在检索已废弃或拆分的旧信息,输出一连串错误结论 。例如,当底层数据库表结构调整而RAG系统未同步更新时,检索结果就会南辕北辙。

- 检索衰退:知识库规模从几百份文档扩展到数百万条记录后,简单的向量检索效率和精度急剧下降,系统开始迷失在海量数据中 。检索命中率下降会导致AI召回无关或低价值片段,影响回答质量。

- 语义噪音:缺乏良好分类和规划的知识库,往往把风马牛不相及的内容混杂在一起 。“撕碎后扔进大搅拌机”的做法会使检索结果夹杂大量不相关文献,模型在冗余上下文中表现恶化,引发更严重的幻觉和误导 。这实际上源于企业对知识划分方法论的忽视,缺少基于业务场景的分类体系 。

- 反馈缺失:许多RAG应用缺乏有效的自动化反馈评估机制。用户很少在对话界面中主动点赞或点踩,导致系统在盲飞:问题累积而团队不自知,直到用户信任消耗殆尽 。

图1:重视知识治理让检索召回准确率在通用场景下提升至100%。

相比之下,AIS知识引擎之所以能够成功落地,在于其系统性地填补了以上空白。以 TorchV AIS 为例,它并非又一个简单叠加功能的RAG工具,而是一个全面的知识引擎:从知识规划、知识加工到知识运营,形成闭环的方法论 。TorchV AIS的设计初衷不是在理论真空中拍脑袋想出来的功能堆砌,而是源自服务多家银行、物产中大和浪潮信息等大型企业过程中,对复杂高风险场景问题的淬炼和最佳实践的凝结 。这种理念上的差异直接决定了结果上的差异:

- AIS强调知识构建:从战略高度规划知识库结构,避免数据混沌。从源头治理确保输入高质量知识,从根本上提升检索纯净度和答案相关性 。

- AIS强调知识应用透明:通过白盒化机制提升可解释性,确保每一步检索和生成都有迹可循,方便企业在高风险场景下调控审核 。

- AIS强调知识健康运营:把知识库当作持续运营的资产而非一次性的项目,引入监控与反馈闭环,及时发现并清理重复、冲突、过期知识,使知识库的价值随时间不降反升 。

换句话说,RAG更多停留在技术实现层面,而AIS建立的是一套从构建到维护的知识运营方法论。后者为企业提供的不仅是工具,更是确保AI项目成功的思想体系 。事实证明,这种方法论上的护城河使得AIS即便在规模化、严格监管的场景下(如金融业)也能稳定可靠地发挥作用 。总之,RAG失败的教训在于忽视了知识本身的治理与演化,而AIS成功的关键在于把知识视作战略资产来精心构建、管理和优化。

知识构建

要打造高质量的企业知识库,第一步是知识构建——这相当于AI领域的“ETL”(Extract-Transform-Load)过程。企业原始知识往往分散且杂乱:散落在不同部门的业务系统、文件夹、个人电脑中,格式多样、质量不一 。任何成功的AI应用都必须从整理这团“数据毛线球”入手,将原始数据混沌转化为结构清晰、质量可靠的知识资产 。

1. 知识规划

与其匆忙地接入数据,不如先从全局规划知识库的结构和边界 。TorchV AIS 的经验是先厘清知识的生产者和消费者:如果知识的维护者和使用者是两拨人,那么应当将知识库分为面向内容生产的“知识仓库”和面向应用/消费的“知识空间” 。接下来按照组织架构、业务场景或产品线等维度对知识仓库进行划分,使不同领域的知识在隔离的环境中优化处理,避免互相污染语义 。举例来说,银行一般将知识库按部门划分,制造销售一体化的企业则可能按场景划分(如售后、维修、营销等),确保每个领域的知识都有清晰边界、各自演化。这一步看似简单,却奠定了知识分类体系的雏形,为后续处理定义了单一可信源(Single Source of Truth)的基础,也基本定义了知识的管理职责。

图2:知识库主页以及知识来源/数据来源。

2. AI-ETL处理

在完成顶层规划后,需要通过可视化编排的管道将多源异构的数据转化为AI可用的知识 。这一过程涵盖“抽取-转换-加载”三大环节:

图3:知识构建系统中的可视化知识加工模块。

- 多源连接:支持广泛的数据源接入,包括非结构化文件(PDF、Word、Excel、PPT、TXT、Markdown 等)、结构化数据库,甚至实时的API数据流 。这是搭建企业内部知识网络的基础能力。

- 深度解析:企业知识库常常充斥复杂文档(多栏PDF、嵌入表格/图表的报告等),传统解析工具容易在这些内容前挂零。为避免信息丢失和错乱,需采用强大的文档解析引擎对原始文件进行结构化提取。TorchV AIS使用了自研的 torchv-unstructured 引擎来更精确地提取表格和图表中的关键数据,确保知识的完整性和准确性 。

- 智能分块与索引:将长文档拆分成语义合理的知识切片(chunk)供向量索引,是知识加载的关键一步。如果采用“一刀切”长度分段,可能破坏语义完整性。平台应根据不同文档类型选择合适的切分策略(如合同、手册、报告可能各不相同),最大化保留上下文语义 。同时,嵌入向量模型的选择也需与上层大模型协同优化,以提高检索效果 。通过这些转换,原始数据被加载成结构化、可检索的知识库。

3. 冷启动分类

当企业积累了海量知识却缺乏分类体系时,如何让知识库“有章可循”?TorchV 提出的解决方案是冷启动聚类分类。它利用无监督学习先对文档向量空间聚类,自动生长出分类树 。具体而言,系统会在无需人工拍脑袋的情况下自动估算最佳聚类数 K,对所有知识向量进行聚类并持久化存储,以供版本迭代和回溯比较 。然后,从每个聚类的中心抽取代表性文档,调用LLM为该簇生成分类名称和描述(即AI自动命名) 。这个过程中产出的分类只是初稿,之后交由运营人员复核确认,确保分类体系符合业务语境 。如此一来,从一团杂乱无章的文档中提炼出具有代表性的类别,让知识真正做到“有章可循”,并成为后续检索和运营的稳定坐标系 。值得一提的是,这种冷启动分类不仅速度快,更注重可控性:聚类过程支持分批分桶以降低资源占用,长任务可暂停/恢复,进度透明可监控,确保在大规模数据上稳定运行 。最终,分类结果还会版本化存档,支持A/B对比和持续优化 。在实践中,这棵自动生成又经人工打磨的分类树迅速为企业知识库奠定了框架,使后续的知识检索、评估有了明确边界 。

4. 多维度分类视角

构建分类体系时,建议引入多维分类的理念,而非只按单一层级划分。企业知识通常可以从多个角度归类,例如按照组织部门、业务场景、内容类型等。下面举例展示多维分类如何为知识管理带来更高的精细度和实用性:

| 分类维度 | 示例分类 | 分类意义与作用 |

|---|---|---|

| 组织维度 | HR人力资源知识、IT运维知识 | 按照组织架构划分知识领域,隔离不同部门内容,避免语义干扰,提高检索准确性。 |

| 场景维度 | 客户支持知识库、产品研发知识库 | 按照业务场景划分知识库,针对特定应用场景优化内容和检索策略,更精准地满足场景需求。 |

| 内容类型维度 | 政策制度、技术手册、常见问答 | 按内容形式与性质分类,方便针对不同类型采用合适的解析、索引和查询策略,提高处理效果。 |

通过以上多维度的分类视角,企业可以建立分类标签体系(Tagging)对每条知识进行多角度标注。在实践中,先通过冷启动生成初步的单维分类树,再结合业务需要扩展出标签体系,为知识打上部门、场景、类型等标签。这种多维组织方式能让知识各就各位:既方便按需组合,又能避免“一锅煮”的语义噪音问题 。总而言之,扎实的知识构建过程为AI应用打下了高质量知识底座,让后续的检索增强生成有源可依、有章可循。

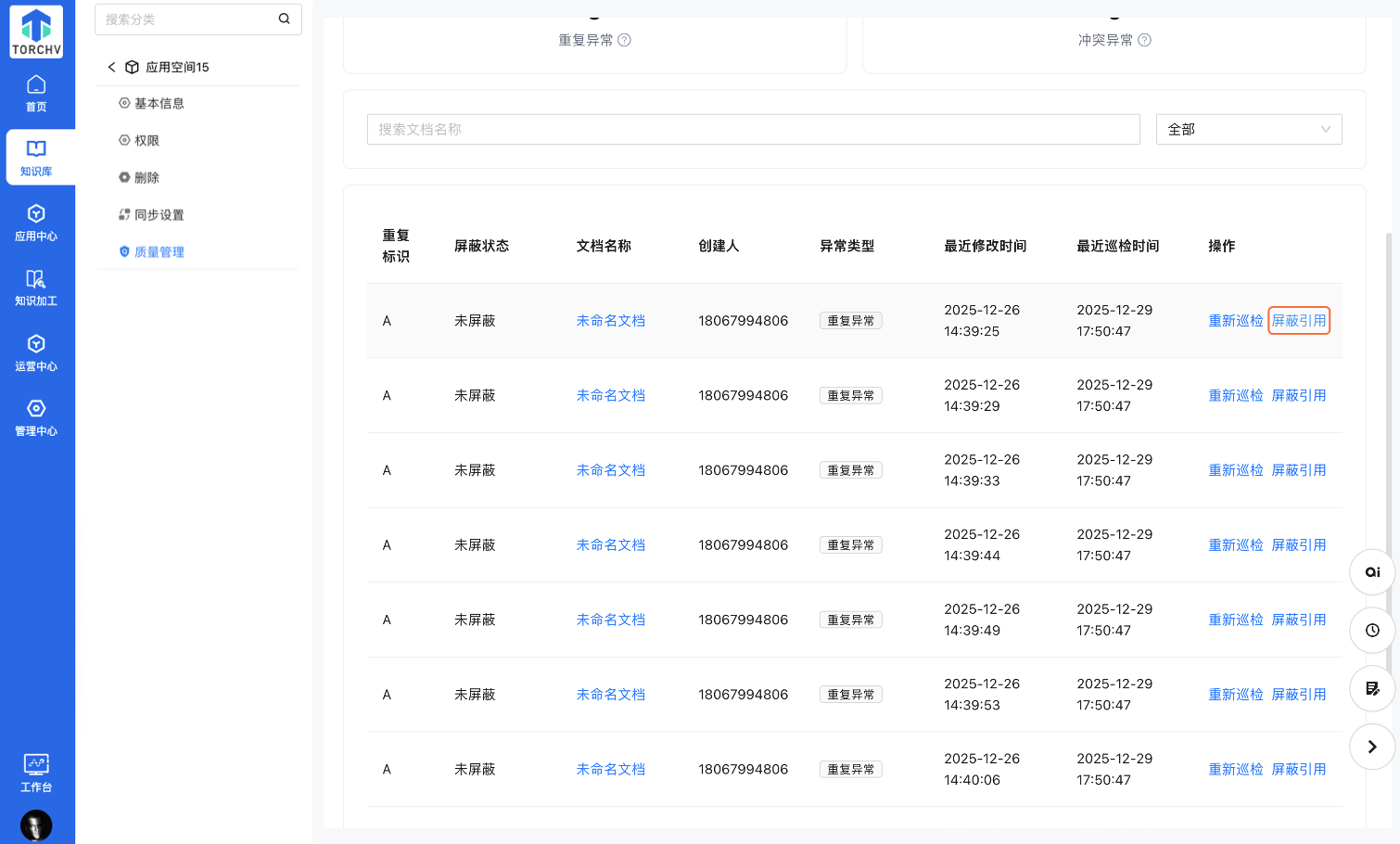

知识健康

知识构建完成后,另一个持久的挑战是知识健康维护。企业知识库不是搭建完就一劳永逸的静态仓库,而是需要持续运营才能保持生命力 。正如人体需要新陈代谢和免疫机制来保持健康,知识库同样需要定期“巡检”和治理,以清除重复、解决冲突、更新过期内容。这些工作过去往往依赖人工零散维护,而现代知识引擎已经将其自动化、体系化,融入日常运营流程。例如 TorchV 提供了“仓库巡检 + 空间巡检”双层机制,把指标变成行动,让系统自动发现知识库中的异常并输出可治理的清单 。下面,我们分别介绍知识健康维护中需要关注的几个关键方面:

图4:知识健康系统里的质量管理模块。

重复知识检测:识别知识库中内容高度雷同的文档,并进行去重处理。重复的知识不仅占用存储,更可能在检索时造成干扰,甚至让AI因同一答案来源有多个版本而困惑。系统应能自动聚类出重复组,提示哪些文档内容基本一致,建议保留唯一版本、移除冗余 。TorchV 空间巡检通过对文档摘要向量的相似度比对和 MinHash 算法,以及段落覆盖率分析,来综合判定重复文档 。巡检结果将重复的文档集合显示为一组,让运营人员一目了然地看到哪些是重复内容,进而进行合并或删除 。这种自动化的重复检测,有效防止了“一个问题多个答案”的混乱局面。

冲突知识检测:定位知识库中相互矛盾的内容,并进行冲突消解。随着时间推移,不同部门可能发布了涵盖同一主题但结论不同的文档,例如两个文件对同一产品参数给出不一致的数据。这类冲突如果不加以控制,AI可能随机引用其中之一,从而答非所问或自相矛盾。为此,系统需要检测冲突组:找出那些主题相同但关键表述相异的文档 。TorchV 的做法是针对潜在冲突的文档提供差异证据,例如标记出字段或句子的不同之处 。然后将这些冲突文档归为一组供人工复核 。典型巡检结果会提示:“文档A和B都在描述X流程,但A称操作步骤有5步,B称有6步。”此时需要人工介入核实真相,更新其中一方的数据以消除冲突。从知识运营角度,这一机制把潜在的知识冲突显性化,避免了AI回答时因底层知识冲突而出现幻觉或张冠李戴。

过期知识检测:发现不再可靠或鲜活的内容,并及时更新或淘汰。企业环境瞬息万变,知识库里的很多内容会随着业务和时间变得陈旧——例如过时的规章制度、几年无人访问的文档等。如果任由这些“僵尸知识”堆积,AI很可能检索到过期信息而误导用户。因此,知识运营需建立机制监控知识的更新频率和使用活跃度。TorchV 在分类维度下统计每个类别知识的更新时间中位数,自动标记哪些类别更新缓慢,发出 NORMAL/LOW/URGENT 警示 。同时,系统追踪每篇文档的问答调用、搜索点击等使用行为,引入周期权重计算活跃度评分,将连续低活跃或不活跃的知识列入治理清单 。简单来说,就是找出那些长期无人维护、无人使用的低频知识并标记为过期候选 。对于这类内容,知识管理员可以选择更新内容或将其归档,从而保证知识库保持“新陈代谢”。自动化的过期检测避免了知识库成为信息坟场,让AI常用常新。

上述三类知识健康问题检测后,平台通常提供一系列运营动作来处理异常。以 TorchV 知识空间的巡检为例,当系统列出了重复组或冲突组后,运营人员可以对特定文档执行以下操作 :

- 屏蔽引用:暂时从空间中移除该文档,即“软删除”,使其不再参与AI的检索和回答(但物理文件保留备查) 。这适用于发现某文档内容有问题但一时无法修复的情况,先将其排除避免危害继续扩散。

- 取消屏蔽:对于误判或已修复的文档,可恢复其在知识库中的可见性,使AI重新将其纳入检索范围 。

- 源头修复:对于内容冲突或过期的文档,往往需要在底层知识仓库中更新其内容。更新完成后,运营人员可以点击“重新巡检”,系统会重新扫描已修改的文档并更新检测结果 。通过这种方式,实现知识库从发现问题到修复问题的闭环。

图5:屏蔽引用即对知识库中的文档进行“软删除”,暂时不参与AI的检索和回答。

值得注意的是,知识健康运营不仅依赖系统自动化,更需要人与算法的协同。机器可以高效地发现重复和冲突,但最终确认哪些内容删除、哪种说法为准仍需要业务专家决策。这正体现了下一节将讨论的理念:将单一真源和本体结构赋予系统,以减少冲突,同时让人工参与形成闭环,不断改善知识库质量。

SSoT、本体与人协同

要让企业知识库在复杂环境中长期保持高质量,单靠算法远远不够,还需要从架构层面设计出人机结合的治理机制。很多业界领先的企业已经探索出一套三层闭环架构:单一可信源(SSoT) - 本体(Ontology) - 人工监督(HITL)。这三层各司其职,又相互配合,形成知识持续进化的闭环。注意的是,TorchV AIS目前还未完全实现SSoT和Ontology,但确实在近3个月的版本规划中。

图6:本体论。

- 单一可信源 (Single Source of Truth):单一可信源指为每个重要事实或知识确定唯一可信的权威来源。在知识健康维护中,引入SSoT可以从源头上减少重复和冲突。例如,对于一项业务政策,只保留由权责部门发布的最新版本作为有效知识,其它过时版本予以归档。建立单一可信源意味着企业需要梳理知识权威:明确哪些系统或文档库是各类知识的终极权威出处。一旦SSoT确定,AI应主要面向这些权威源检索答案,从而避免“各唱各的调”的情况。实践案例显示,大型组织在数字化转型中非常重视SSoT。比如跨国制药企业诺和诺德(Novo Nordisk)在推进本体化数据管理战略时,就强调以中心化的本体作为数据的单一可信源,以确保语义一致和准确 。通过统一的来源管控,企业可以大幅降低知识冲突发生的概率——因为对于每个问题,AI只需参考经审批的权威内容。

- 本体体系 (Ontology):本体是在概念层面对知识的结构化表达,它定义了业务领域中的实体、属性、关系,相当于知识的“蓝图”。构建企业级本体可以帮助统一不同系统、不同时期知识的语义,打通知识孤岛。更重要的是,本体可以承载SSoT:将权威数据源映射到本体的中心概念上,充当知识融合与对齐的平台 。目前一些金融和制药等行业的企业中的经验表明,基于本体的数据管理不仅天生符合 FAIR 原则且具有可扩展性,还能在数据生产者和消费者之间架起桥梁 。他们通过构建企业特定的本体模型,使公司沉淀的大量异构数据实现语义对齐,并作为唯一事实来源服务各类应用 。当然,本体的开发和维护本身也不容易:需要专业人员梳理业务概念,继承公共本体又扩展出定制本体以契合组织需求 。但投入是值得的——一个成熟的企业本体就像一部“知识说明书”,让AI可以按照说明书去理解和调用企业知识,极大提高准确性和一致性。另外对于多业务单元的大型企业的审计部门来说,使用本体作为企业各业务单元运行的“数字孪生”沙盘,可以有效帮助审计部门提前发现业务中的问题,而不是通过低效又脱离实际的调研表。

- 人在回路 (Human-in-the-Loop):再完善的自动化系统也无法穷尽所有判别,特别是在知识质量和策略决策上,人类专家的参与不可或缺。HITL机制贯穿于知识构建和运营的各个环节:从冷启动分类时运营人员复核类别命名 、到冲突处理时业务专家裁定真值、再到反馈训练时根据用户评价调整模型等等。以知识冲突处理为例,系统可以检测并标出两份文件的数据不一致之处,但最后仍需人工确认哪个数据有效,然后更新知识库。TorchV 的巡检平台就设计了人工交互入口,让运营人员决定对异常文档是屏蔽、删除还是修改后解禁 。通过将人融入循环,企业知识库实现了自我进化:机器发现问题→人解决问题→机器验证更新→知识库质量提升→再次进入下一轮循环。HITL保证了当AI无法判断时有人类兜底,把最终的知识定夺权牢牢掌握在企业手中。

综上,单一可信源、本体和人在回路三层架构共同筑起了企业知识引擎的“健康防火墙”。单一可信源提供权威统一的知识来源,本体确保知识语义结构的稳固和一致,人工在环则为系统注入专业智慧和治理判断。这三者相互配合,形成闭环治理:权威知识进入系统→ AI应用知识→ 系统监控反馈→ 人工审核修正→ 知识更新回流权威源。真实企业案例(如诺和诺德 )已验证了这一架构的价值:他们通过本体+SSoT策略,将数据质量和一致性提升到新高度,为AI赋能研发提供了坚实基础。

从技术深度和可操作性的角度来看,以上方法都是企业可落地的。关键在于意识到:AI项目成功不止取决于模型本身,更取决于背后知识的质量和持续运营能力。我们需要对传统RAG方案保持批判性思维——不能幻想把所有数据粗放地倒给大模型就能得到可靠答案,而要建设面向企业的知识基石:打牢知识构建,严抓知识健康。唯有如此,AI 才能真正融入企业业务,成为长期可用、可控、可优化的生产力工具,实现从“一时惊艳”到“持久实用”的转变。