本文导读:

- 实际业务中应该如何使用大模型的思考

- 记录一款大模型产品的0到1过程

在公司已经六年多了,六年多里收获很多成长,从纯研发leader开始,先后带过大数据产研团队、AI产研团队和运营团队,而且还作为独立销售和解决方案获得一些著名客户的订单,从一个coder变成了多面手。所以,在即将离别之际,不去讲其他纷争,只从产品角度去写两篇文章总结过去。上篇写今年之前三年的一些感想,主要记录力石小知的成长——《总结一下过去三年的产品心路》。这篇写的就是今年,在大语言模型(LLM)开始进入国内之后,我们如何思考它带来的影响,以及如何务实去落地一款产品。

本文有7000多字,有点长,Enjoy!

一、对大模型技术的积累

看过上篇的朋友应该知道,我们在2019年就已经开始了AI产品的研发,并且这几年有一定的市场品牌口碑和数据积累。也正因为有这样的“AI传统”,我们才有一定的人才储备(比如我们的小胡,B站ID:良睦路程序员,Github:yuanzhoulvpi2017),所以当今年大模型这波新的AI浪潮袭来的时候,我们算是入局比较早的:

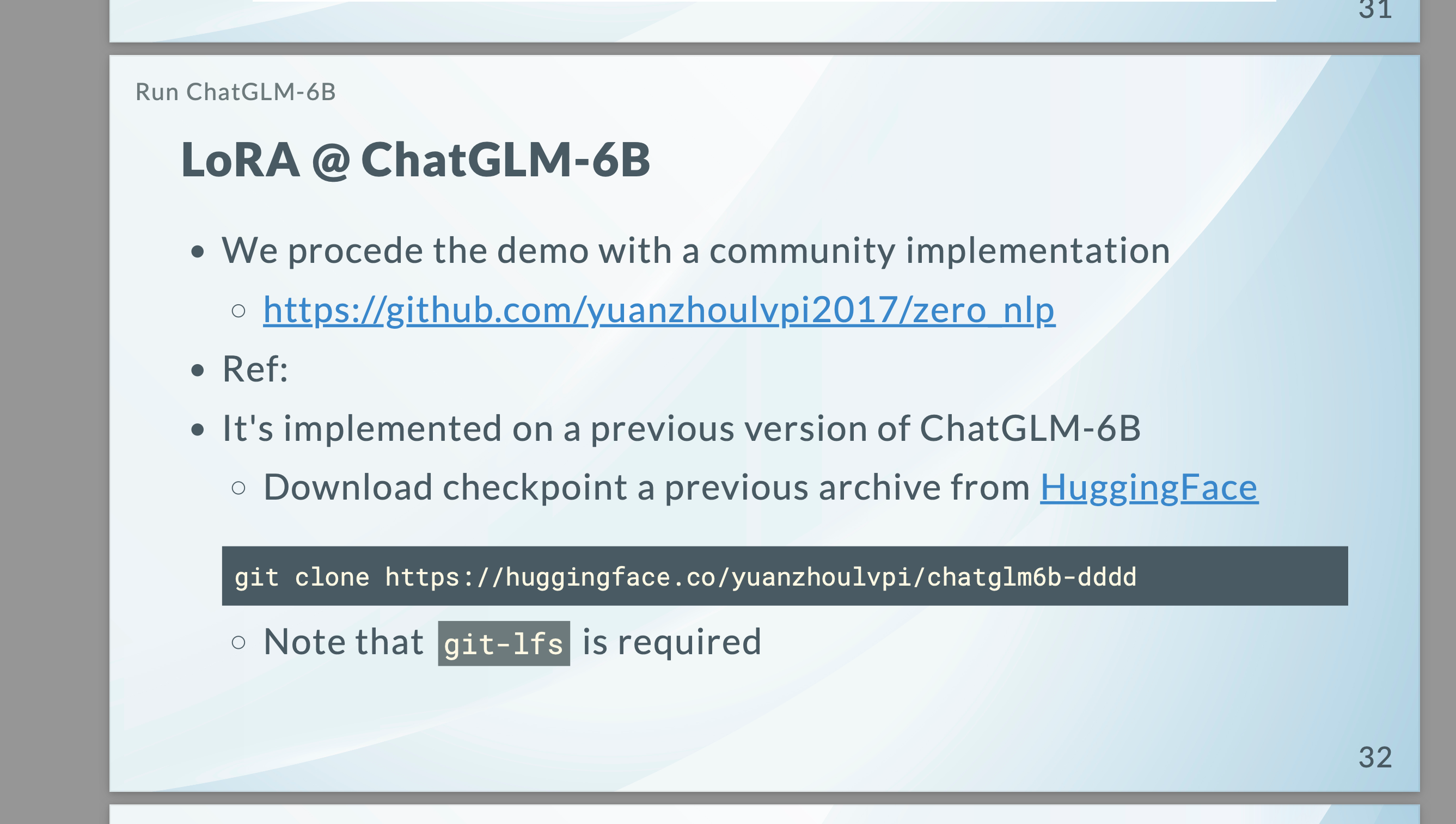

- 参与大模型社区:在今年2月份,我们团队发布了最早的ChatGLM-6B社区版LoRA版本代码——(见下图)获得智谱官方PPT的介绍,这个Github Repository就是我们团队的;

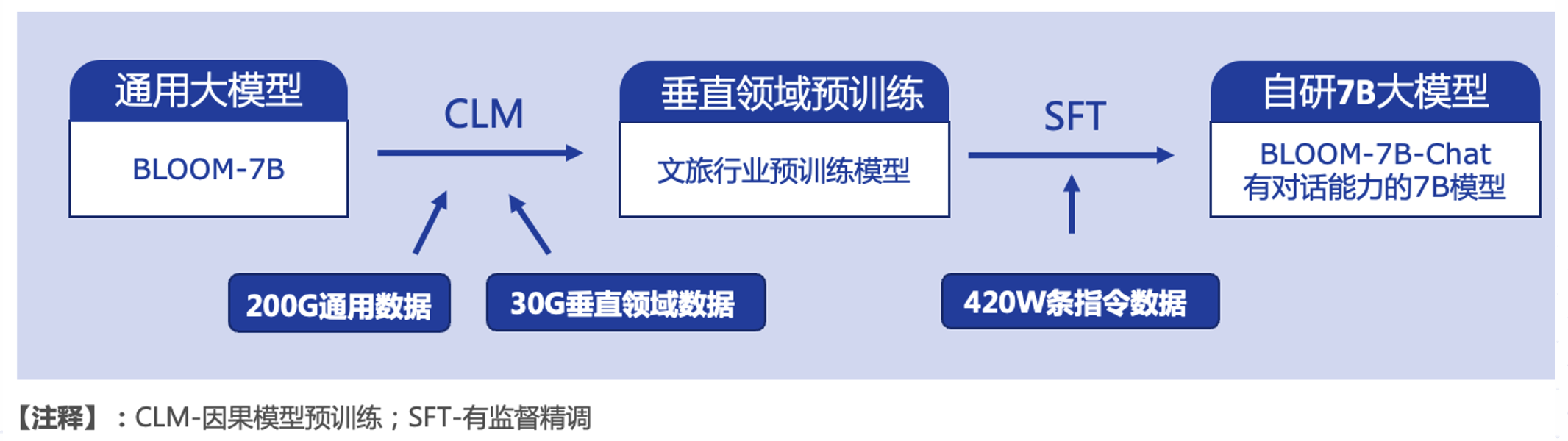

- 发布商用大模型:3月份我们基于BLOOM-7B训练了自己的可商用大模型,是从CLM(因果模型训练)开始的全量训练,到后面的SFT(有监督精细微调),也因此获得某大厂和两家运营商的合作。当然后面因为要发证,我们知道自己无法在近两年内获得牌照,因此也就掉头重点转向大模型应用了;

- 打造大模型应用:使用大模型改进上篇提到的产品——小知,原来小知基于BERT,现在变成BERT在前,GPT在后兜底的双模型系统。另外更重要的就是创造了一个基于大模型的新产品,这也是本文后面重要要讲的内容。

而且相对其他同行来说,我们还有一个独特的优势就是数据积累。

小知3年多服务中产生的数据量极大,且格式就是“问答指令集”,非常适合SFT(有监督精度微调)。有朋友可能知道之前Dolly2大模型发布的时候,他们用了仅仅1.5万条自己生成的问答指令集,就基于gpt-neox训练出了一个很有竞争力的模型。所以就文旅行业来说,我们的微调工作在百万级挑选出来的数据帮助下就相对有效。加上我们有一个很有活力的团队,于是如何将LLM用在产品中就自然而然成为了我们团队的新任务之一。

二、大模型的还有哪些缺点

这次大模型和以往的新技术的出现有所不同,大家一开始都是先从OpenAI的ChatGPT开始的,有点”开局即巅峰“的意思,以至于后面大家接触”车水马龙“会笑得人仰马翻。基于ChatGPT的普及,大模型的优点我就不赘述了,下面我们说说这位法学硕士(这是一个梗)的缺点。

1.大模型的主要缺点

Chat(问答系统)只是最基本的大模型应用,说白了就是OpenAI放出来的一个Demo。我们把大模型应用在企业业务中时,问题依然很多,主要包括:

- 幻觉问题:大模型的底层原理是基于概率,所以它有时候会一本正经胡说八道,比如我们问大模型的Chat(问答系统),“良渚博物院下周一开门吗?”我相信这样的问题你不能连续问,因为大模型会有一定的几率告诉你开门(而实际情况是周一闭馆,除非碰上法定节日)。而如果游客真的在下周一去了良渚博物院,那估计就要失望了。如果这个Chat还是博物院官方提供的,那事情最终会演变成一通12345的投诉电话。所以在很多需要非常精准服务的场景,仅仅依赖GPT这种”盲目自信“的生成式回答是很不严谨的,而且看起来很难消除——目前我们常见的解决方案是前置一个BERT和语料维护,或者使用RAG(检索增强生成,目前正在成为主流)或者预置大量prompt做优化(有公司这么在做)。

- 新鲜度问题:规模越大(参数越多、tokens越多),大模型训练的成本越高。类似OpenAI的ChatGPT3.5,目前的数据新鲜度依然保留在2021年,对于之后的事情就不知道了。而且对于一些高时效性的事情,大模型更加无能为力,比如帮我看看今天晚上有什么电影值得去看?这种任务是需要去淘票票、猫眼等网站先去获取最新电影信息的,大模型本身无法完成这个任务。现在主流的解决方案是增加RAG方案;

- 数据安全:先抛开OpenAI已经遭到过几次隐私数据的投诉。就企业应用来说,如果把自己的经营数据、合同文件等机密文件和数据上传到云上的大模型,那想想都可怕。如果企业人员想提一个类似这样的问题:“帮我看看3月份XX部门的销售环比数据与哪些兄弟部门的增长是密切相关的?”,这需要打穿企业内部的很多数据。既要保证安全,又要借助AI能力,目前最好的方式就是把数据全部放在本地,企业数据的业务计算也全部在本地完成,然后在本地部署参数相对较小的大模型;

- 费用问题:ChatGPT一开始是免费的,到后面开始API调用的收费,再后面出现的GPT-4的价格已经让很多人认识到AI是有成本的。这甚至造成了Langchain、AutoGPT等半自动和全自动的Agent框架立马遭遇冷落~~费用扣的太快了!!

2.国内大模型的问题

上面说的还是OpenAI的问题,再说回到国内,我们的大模型的能力和OpenAI还是有很大差距的,包括一些常用的推理能力。

除了能力上的差距,国内AI大模型及相关产业的从业者还面临着更多的问题:

- OpenAI等大模型的使用限制:即使你获得了GPT-4的API调用权限,依然会被突然封禁。而且国内对于公共应用中使用OpenAI和Claude等外部大模型的限制也是很严格的,所以自己玩玩可以,但真的要企业中对外服务,还是需要正视外部API的问题;

- 政策法规的严格把关:目前包括微信(小程序)等应用端,对于应用中大模型的介入是需要提供各类备案的,大部分公司无法做到(好像有点无解,但是别急~)。

3.我们的选择

所以我们对于大模型在产品中的应用是相对较为谨慎的,目前主要的大模型应用思路包括以下几点:

- 国产模型优先:绝不直接采用国外的大模型API服务,而是采用国内的产品,如智谱/百川/文心一言/通义千问等的API。或者就是分不同使用场景,采用自己本地部署的Baichuan2-13B/ChatGLM2-6B等国产大模型和Llama7B等开源模型。因为采用国外大模型虽然确实很爽,但是会形成整个技术栈依赖,弱化内部真正解决问题的能力;

- RAG优先:RAG(Retrieval Augmented Generation,检索增强生成)做为大模型应用的一种优秀补充,借助向量embedding、相似度匹配等技术,可以将客户给定的PDF、Word和视频等内容快速形成知识对话能力。相对于微调(Fine-Tuning),RAG在知识新鲜度、幻觉和数据安全方面都更容易掌控,特别是幻觉问题,对于后续应用上线时候的审查是非常有效的。而且最关键的是RAG这种胶水组件的解决方案可以很大程度上减轻我们对大模型能力的依赖;

- 预生成优先:我相信现在国内大模型应用到后面最大的成本会是符合法规方面的对齐工作,内部审查也是很多公司的高月活产品最大的人力成本之一(听说B站的审核人员有4位数)。所以我们目前优先考虑的做法是预生成,通过大模型提升生产效率,把以前无法想象的生产成本极大压缩(后面介绍产品的时候会说到),所有呈现给最终用户的产品内容是透明可审查的,避免大模型在生产环境中突然”抽风“。

好了,说了这么多思考,接下来我们开始来说说今年做的这款新产品的0到1.

三、大模型产品启动

1.产品赛道选择

我现在所处的行业是数字农文旅。

农业农村是个大市场,也是国家这几年重点在发展的赛道,各种项目资金可以说非常充沛。但是农村也有一个大问题,就是它是一个大行业,却不是大市场,更多的客户是非常分散的,且不是知识密集型行业,所以对大语言模型并不友好。加上这两年接触下来,涉及的项目还是以形象工程为主,真正的产品力无法深入体现,个人感觉也没有能力真正把产品力做出来。所以放弃数字乡村赛道。

接下来是旅游。很多人可能看到疫情后旅游市场的爆棚,但在行业内,我们可以看到旅游消费依然乏力,City Walk、郊游(公园搭帐篷)等形式火热兴起。对于景区、文旅集团等,目前的日子依然不太好过…。我一个朋友在10月9日截了一个上市文旅公司的二级市场走势图可以说明一些问题。但是最可怕的是,除了一些稀缺级别的景区和一些新型服务形式的景区之外,景区这种靠山吃山靠水吃水的服务形式,正在失去游客…

综合考虑之后,这次我瞄准的是文博行业,更具体的说就是博物馆(院)和遗址公园一类的客户。就像上面说到的City Walk的火热,文博场馆就是大家主要的目的地或参观游玩点之一。

可以这么说,这次产品赛道的选择,我没有去看政策影响和甲方的资金是否充沛这些传统的toG/toB玩法,而是主打toC。这次的甲方更多是站在合作伙伴的位置上,我们是帮助他们一起来赚钱的,所以更看重的是人去了哪里。这个观念也可以参考我之前的一篇文章《进击吧!硬地骇客————独立开发者时代来临》里面提到的市场环境变化。

2.产品构思的产生

因为我是良渚遗址项目(其中旅游这部分)的商务+售前,所以和良渚遗址的领导比较熟。有一次就请教了监测中心的孙主任,他对于文物活化的看法。这一问不得了,确实颠覆了我很多认知,因为之前我对于活化的思考更多实在VR这些方面上,当然基本上都需要大投入大建设。主任对VR/AR也基本上是认可的,但是他说技术不能解决核心问题,他觉得核心问题就几句话:”文物活化,就是要让观众看得懂、喜欢看,看了之后能传播!“(具体意思应该就是这样的,可能用词上更我写的更准确一些)。当时有种被电流击中的感觉,真正的内容如此简单直白。

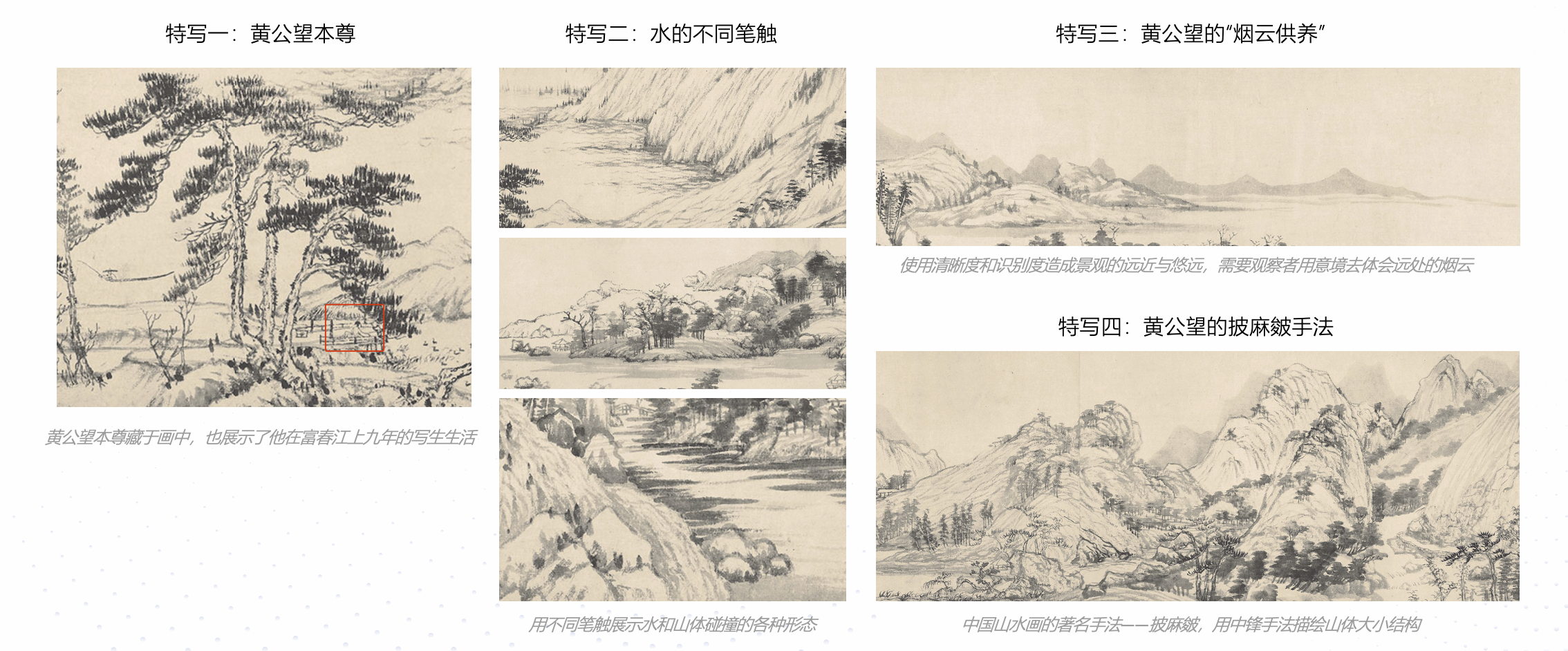

有了这句话的影响,我就去找各种资料加深这种感觉,其中对我帮助最大的是窦文涛的《锵锵行天下·第三季》,里面有一期讲《富春山居图》的,非常精彩,确实讲出了很多我之前自己看展品根本看不出来的道道。

特写一:黄公望把自己也已经画进了《富春山居图》中,也是对他自己在富春江畔九年的写生生活留下一个缩影;

特写二:水的画法和山是有直接关系的,有直接冲刷山体的,有掠过山体的,也有打了回漩到山坳里泛起粼粼波光的,每种笔触是对山水的真实写照;

特写三:通过清晰度和识别度造成远近和悠远,营造江面被一层薄雾笼罩的视觉,通过这种技法,让观察者心中感觉到烟云,既为“烟云供养”的技法;

特写四:披麻皴技法,古代山石画中非常精髓的技法,利用中锋手法,高处做大结构、气势磅礴,低处(离观察者近)构思精巧。

这么一解读,是不是对这幅浙江博物馆的镇馆之宝(浙博只有前半卷,也就是《剩山图》,后半卷在台北故宫)有了更多了解。

通过这两件事,我对新产品有了一些初步构思,就是文化文物不是仅仅靠听就能听懂的,文化文物是需要视听同步才能做到“看得懂、喜欢看,看了之后有谈资”的。于是我觉得这里面是有一个空白市场,而且也是一个风险相对较小的产品——导游讲解机已经有十多年历史了,我们去升级迭代这个产品,去拿这一块市场。

3.产品调研无需太多

我把调研分成两拨,第一拨调研是让我团队的一位我认为比较聪慧的同事(倩文)去的,她走了五个馆,写了大概万把字的调研报告,给了我第一手的信息。也是已通过这些资料,我坚定了做这个产品的决心,这里肯定是有市场空白的。

第二拨调研是我自己去的,而且还邀请了另外两个同事,一位是我们分管副总裁王总,另外一位是我们的产品总监欧阳。这一拨调研我有重点地将目标放在了我自己的原有客户身上。两个客户分别是宁波天一阁博物院和杭州的良渚古城(和博物院)。调研发现其实市面上已经有AR眼镜的产品,外形看上去其实还是挺酷的,但问题也很明显,主要是三点:

- AR眼镜夺走了观众的第一视野,虽然我们带着眼镜,但是看的却是眼镜里面的视频,而不是眼前的文物。而且为了画面清晰,观看时还需要把里面的墨镜盖下来,根本看不见前面的路,造成游客行走困难;

- AR眼镜里面的视频内容更新很不方便,价格贵、制作也非常困难,所以我们调研的其中一个博物馆的馆方人员和我们说,今年已经是合作第15年了,期间却只改了三段视频,因为制作成本有难度,而且成本太高了。

- 没有什么交互,就是到一个点位,然后视频弹出来,说实话和在家里看视频没有太大区别。

对于传统的导游机,它的问题还是无法用画面来展示文物背后的故事。

于是,我觉得也不需要再调研了,因为我已经可以给新产品做定义了。

4.产品定义

我给新产品定的内部名称是”可交互AI讲解“。

下面是给这个产品做的几个定义:

- 降低新产品风险:讲解器市场存在已经十多年,本身就证明了这个市场存在,我们要做的是迭代这些原有的产品,分割一部分市场,产品风险较小,但是市场够大;

- 体验上要优于现有应用:即使现在有手机扫码讲解这些新功能,但是我们会使用iPad作为主要载体,在显示效果、屏幕大小和实用性方面都远超手机,高达5GB的离线资源预安装在iPad里,无需游客自己手机下载,不用担心耗流量和耗电;

- 视频是最佳展现形式:讲解语音和视频画面同步,可以讲解深度内容,比如上面说的富春山居图,只有画面同步才能完美展现出来;

- 交互带来不一样的体验:可交互,观众在使用期间,可以随时进行交互,比如只要说”小知小知“,就可以用语音提问:”黄公望在来富春江之前是在哪里啊?“,交互采用的就是基于大模型的RAG技术;

- 内容快速预生成:这也是支撑整个产品逻辑的底层核心。我希望是,内容运营人员挑选一本关于目标文物的电子书并上传,系统就可以自动将电子书内容做解读,分离图文,提取出很多小故事,然后自动生成一段一段的讲解视频。这才能满足100x的内容制作效率,才能时常更新内容,也能满足快速扩张的需要;

- 合作大于项目:前面我也说了,这个产品我希望是toC的,所以我和客户的关系其实是平等的,我把产品放在你这边,让游客/观众付费使用,然后我们一起分润。这种方式比我们之前项目制打法要快很多,而且赚的是现金生意。

基于这6点,我已经可以规划处一个产品了:

前端

一个iPad作为主要载体,搭配耳机,播放的是关于当前文物的讲解视频。

后端

后端的核心是使用AI进行自动化内容生产,但是我们不会真的去追求一步到位,而是先使用半自动化的方式。前期会让内容编辑人员参与内容建设,然后记录他们的生产过程,结合上线之后的用户喜好数据,逐步进行全自动内容生产流程。

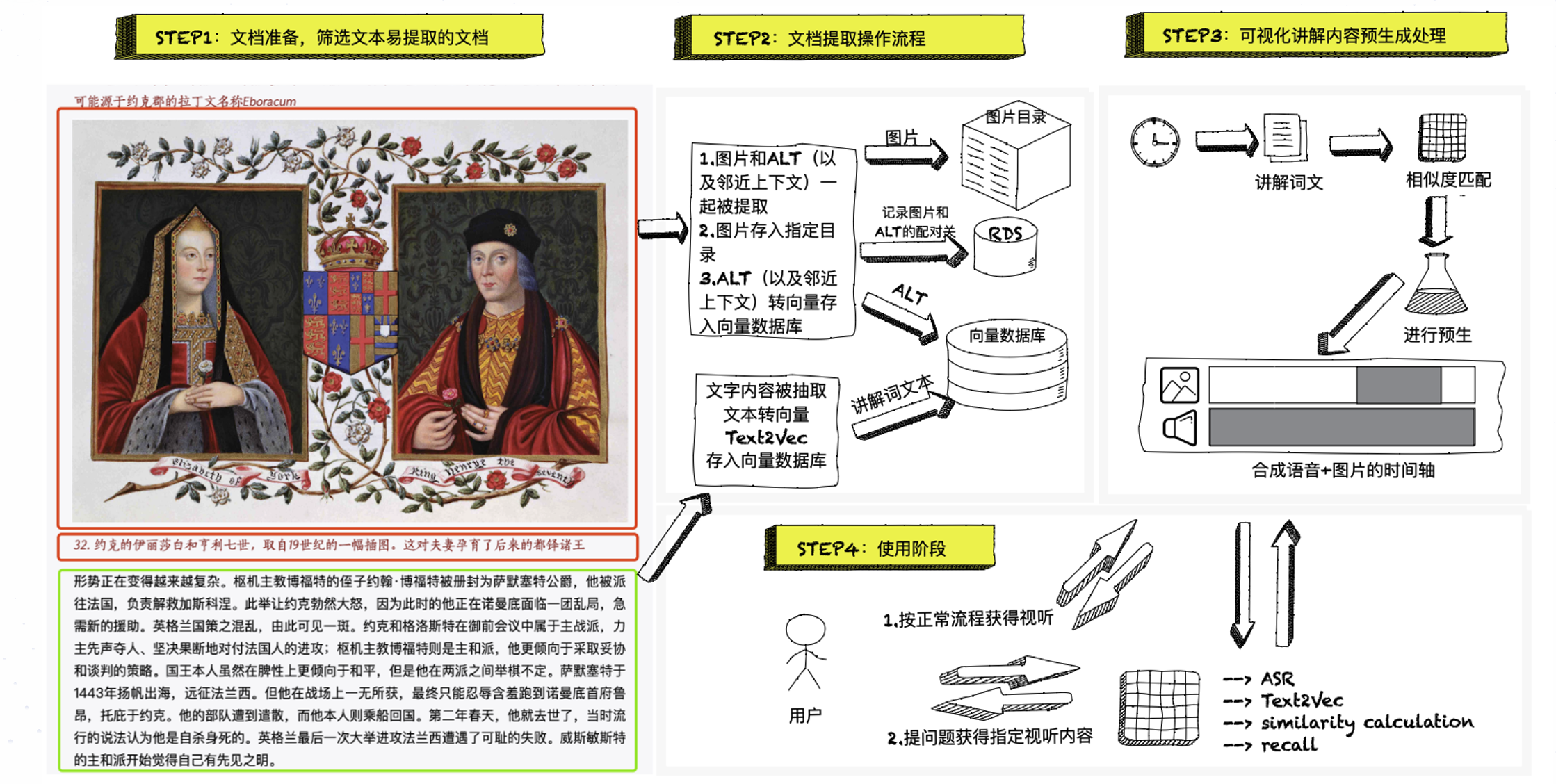

后端的简易流程图如下:

Step1:内容运营人员挑选有趣的内容,一般是电子书、论文和网络内容,当然需要经过馆方审核。然后将内容制作成PDF、Markdown等格式,上传到系统;

Step2:系统的调度程序(TaskScheduler)开始运行,将文档进行内容提取;

Step3:图片的提取相对复杂,首先单独存储图片,如果有图示文字的,存入图片相关的描述文本;如果没有图示,那么将图片上下文存入图片描述文本;或者还有一种就是文本中有下标(比如[3]),图片在章节末尾的,那就存在下标的上下文到图片的描述文本。图片的描述文本进行embedding处理。描述文本和图片直接的实体关系通过RDS进行对应(多对多关系);

Step4:提存和存储文字,会先使用大模型进行润色,在Prompt里面设置较多角色、指令和带有行业knowhow的输出格式模板。润色之后的文字进行embedding处理。

Step5:中间略去一些处理细节,然后再以讲解文本为基础进行时间轴创建。讲解文本的chunk_size基本上是以句子为单元的,将讲解文本与图片描述文本进行语义匹配(相似度算法),自动组合视频时间轴,生成一段”伪视频“。为什么是”伪视频“,因为这时候其实是一个mp3播放器和一个带有转场特效的图片播放器的叠加。这个期间,运营人员可以对内容进行最后的调整;

Step6:合成最终视频的过程其实非常简单,其实就是录屏。

说实在的,这可能只描述了整个过程的50%流程,后面不断优化之后,整个流程不断增加新功能,整个生成过程也在不断完善。里面用到的技术也非常繁多,包括:

- ASR

- TTS

- Embedding

- 向量数据库

- 大语言模型(GPT)

- NLP、BERT

使用场景

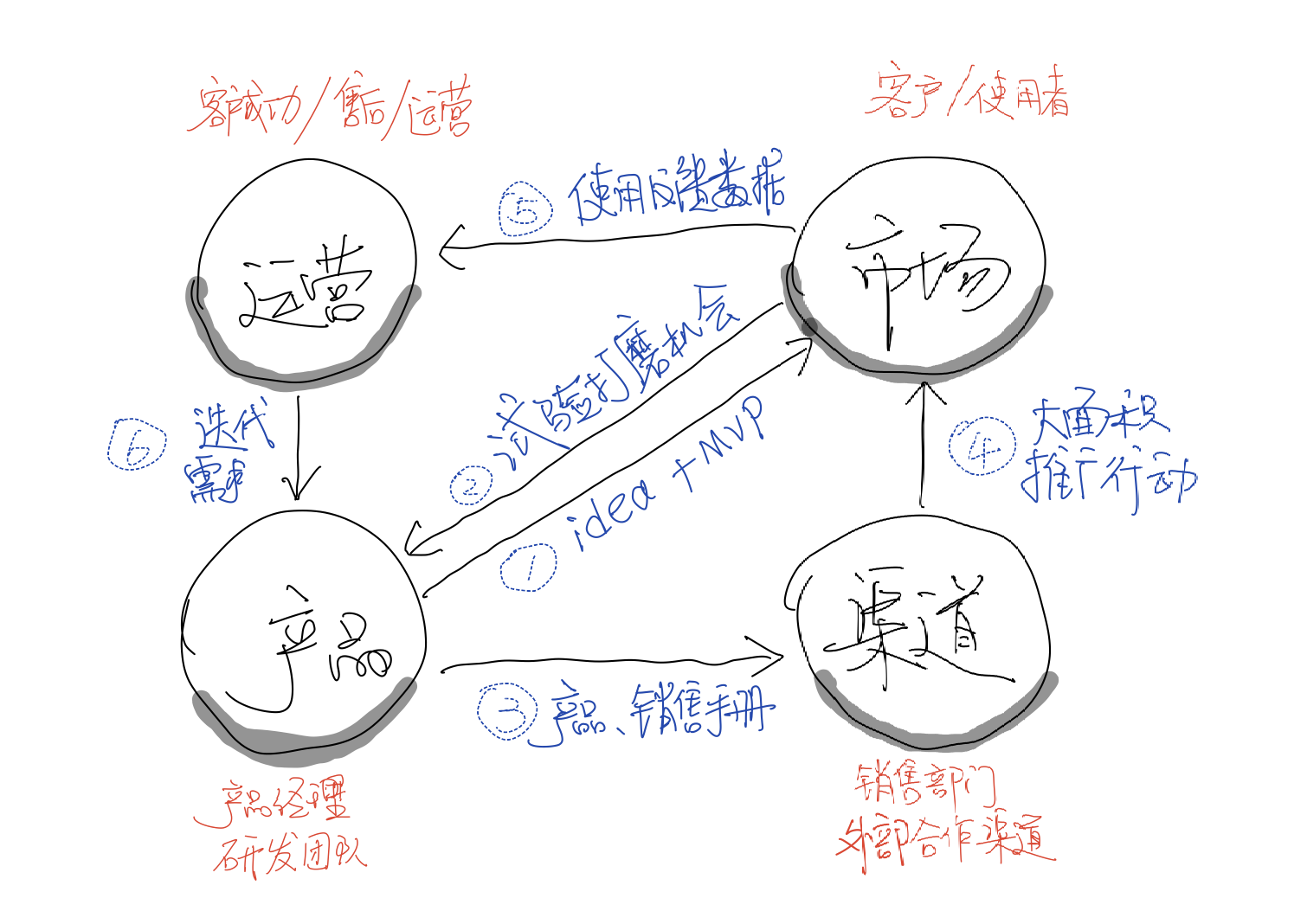

其实定义使用场景这个工作是在我们第二拨调研之前做好的,这次调研我们面向是业内专业人士和馆方领导,需要有PPT做演示,要让对方快速理解使用场景,才能获得市场成功。如果你看过我上一篇文章《总结一下过去三年的产品心路》的话,是不是”产品-市场对角线“的感觉又出来了。

你知道,仅仅靠语言描述是很难把一个产品讲清楚的,即使你会画一些简单的线框图,对于其他行业的人来说也不好理解。所以有必要用相对真实的画先描述一下使用场景。我们这个时代最大的好处就是有各种AI工具可以帮助我们完成自己不擅长的事情,比如我不是画家,也不是摄影师,但是我依然可以用Midjourney画出脑海中的使用场景,于是,就有了下面这两张图:

四、产品研发过程

这个过程我肯定不太像说的太多,因为细节太过于繁琐,即使讲出来可能也索然无味,加上我也确实不能说太多,但有两点我觉得是可以分享的。

1.组织保障

读过之前《三年产品心路》的朋友应该知道我之前带队做小知的时候,开始的半年是靠实力生撑过来的,人员抓肩见肘。但这次不一样,老板把AI产品线定义为公司最重要的核心竞争力,加上VP王总加入之后,确实为这个产品注入了相对丰富的产研资源。

产品由公司P序列最高的产品经理欧阳(P9)负责,研发方面也是P8、P9的同事领衔,比如我经常提到的著名开源作者小明,还有公司最好的前端六木。当然AI算法和大模型方面参与的还有最开始提到的”良睦路程序员“小胡。付萍带的内容运营团队也全数参加,前面提到第一次调研的倩文负责整个产品研发进度的把控。

整个产品团队最多有16人,常规也有9人,对我来说,这次打的就是富裕仗。所以欧阳经常感叹的一句话是,两个月前还只是一份PPT啊,现在就已经出来v0.8版本了。总结下来,组织力量是非常重要的,没有组织能力的保障,很多产品出不来:市场+产品+研发+AI+运营+项目管理,这样的团队配置我相信在我们行业内是不太有的,所以我对于分享产品过程也没有太刻意的保留。

2.不断迭代

”产品-市场对角线“里面很重要的一点就是持续收集需求,然后迭代升级。

这次我们拜访了多家潜在客户,收集了大量需求,最终选择在宁波天一阁博物院首先落地。原因可能是他们刚好有一个展会的契机,而且黄主任是我觉得为数不多的既懂技术(包括大模型)又懂文博专业知识的专家。我们和天一阁联名参办宁波数字经济展会是一个非常好的机会,因为如果只是和黄主任聊聊天,我觉得很多建议不会太深刻,因为和他自身没有太大利益关系。而共同去办展,他在很多时候比我还重视这件事情,所以获得的需求是真切的。

五、后记

可交互AI讲解(后续可能会改名为”文博佳“)现在已经处于落地阶段,要处理的细节还有很多,11月份会在天一阁博物院率先落地。后面的几家意向博物馆也基本上做了联系,获得口头认可。

这算是又一个从Idea到产品的过程,不过这次理论推导更充分,也算是我在公司创造的第四个产品。这次的历程,最重要的是使用大模型对于实际业务结合的探索,虽然这次大模型在整个产品的技术组成中占比没过30%,但也是一个有意义的尝试。我们做产品最重要的不是炫技,而是要最终呈现用户价值,大模型、向量等在中间起到的作用是解决了内容生产效率的问题,这样我们才有胆量在前端(用户端)做到高要求,不然产品的持续力不够,内容断档,也最终只是昙花一现。

我目前更聚焦的是RAG方面的研发,大家都大模型、RAG感兴趣的话,可以关注我!